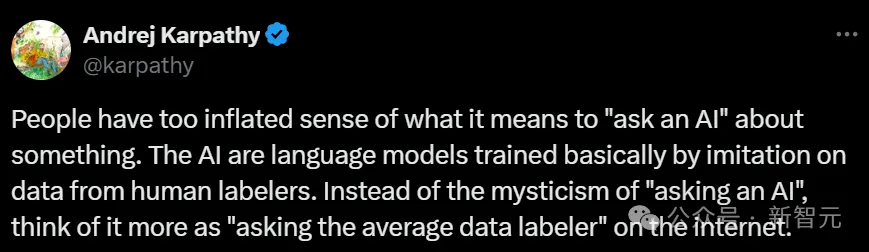

现在,人们把向AI提问这件事看得过于神奇,但背后其实是普通的数据标注员在辛勤工作。这种现象确实值得我们深思。

向AI提问的真相

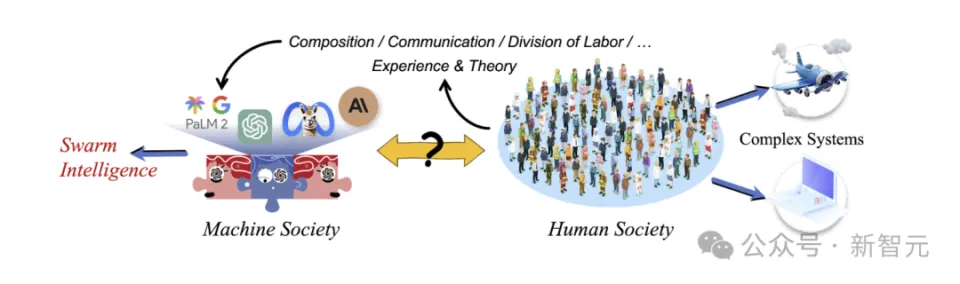

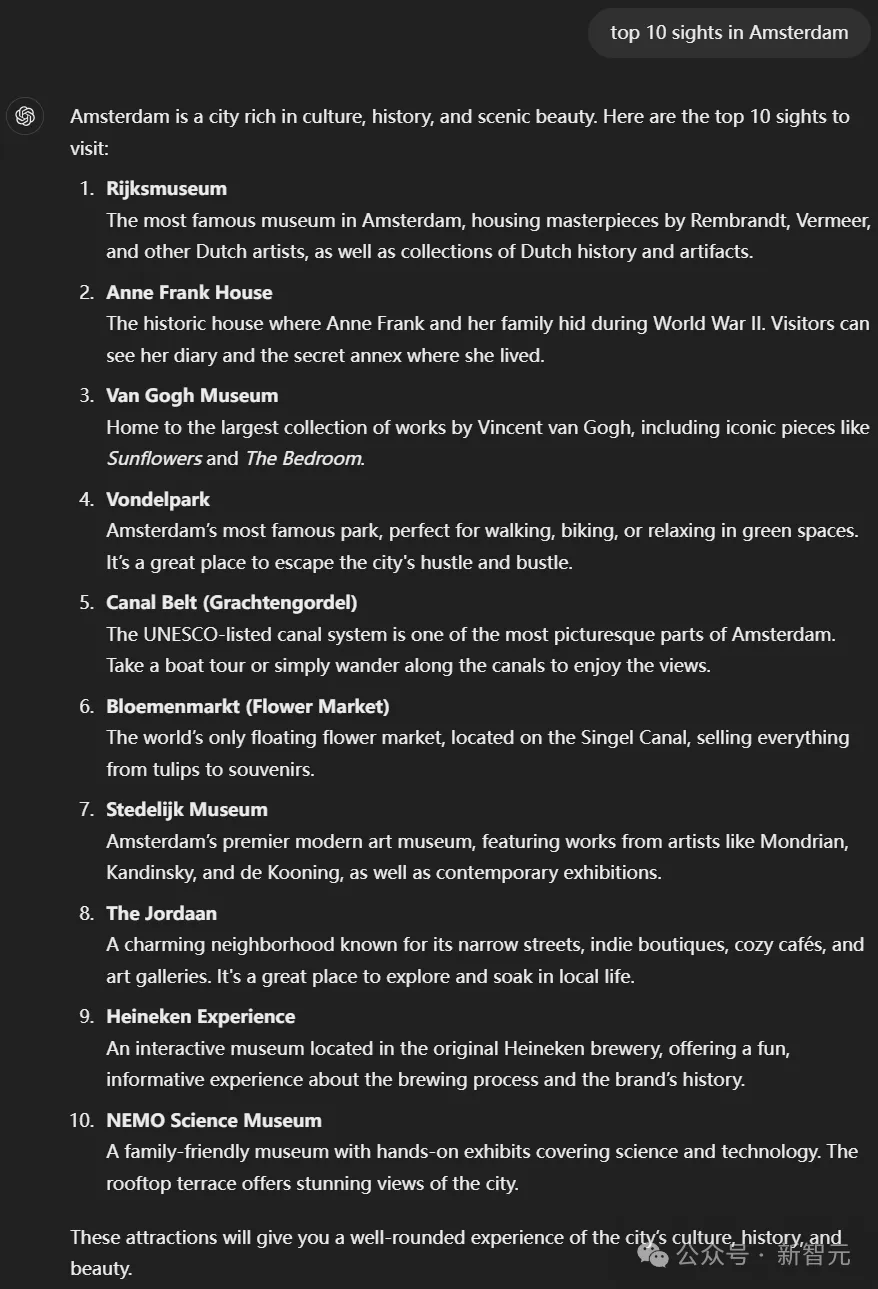

许多人觉得向人工智能提问就像是在和超凡智能交流。但实际上,目前的人工智能回答很大程度上依赖于背后的人类标注员。以强化学习为例,它并非完全成熟的强化学习技术,人在答案的制定中扮演了重要角色。这些标注员的知识集合被转化到大型语言模型中,形成了我们看到的回答。而且,多数情况下,我们只是通过他们来获取信息,并非真正在与人工智能进行神奇对话。

我们要对AI有一个全面的认知,不能一味地过分夸大它的能力。需认识到,其背后实际上涉及众多人为因素。

RLHF实际状况

RLHF又称基于人类评价的强化学习技术。就目前来看,该技术能达到的最佳表现,可能只是领域内专家会选择的结果。然而,这种性能受到诸多限制。例如,在数学领域,如果基础模型的知识深度不足,推理能力较弱,那么它与真正专家的水平仍存在差距。强化学习并非如人们想象的那般完美,实际上,它还存在不少局限。

在许多领域,这种差异尤为突出。例如,在那些容易定义奖励函数的领域,与那些较为复杂的领域相比,RLHF的成效显著,但与所谓的“超人级别”相比,仍有较大距离。

Laws与模型预测能力

模型输入与输出之间存在某种联系,这便是所谓的Law。然而,目前关于Law的研究大多集中于模型在数据集中对下一词的预测能力,比如GPT系列模型的一些特定功能。但这样的研究与现实世界中的任务表现存在差异。正如JasonWei所提到的,目前尚不明确这些替代指标是否能够预示能力的涌现,而且它们之间的关联性也尚未得到充分的研究。

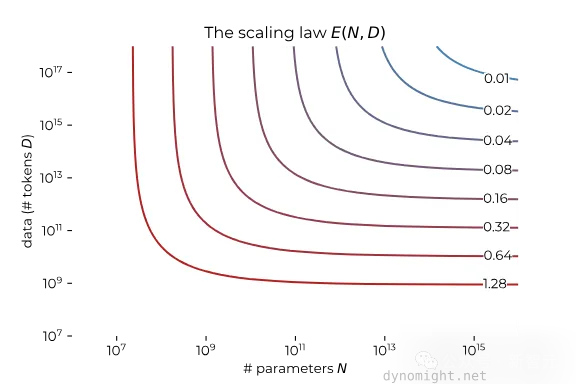

在这种情境下,仅凭现有法律来评估模型能力并不可靠。对于数据量和计算量,如何准确衡量模型的表现,这是一个需要深入探讨的问题。

拟合Law与模型表现

为了更精准地预判模型在实际应用中的效果,我们尝试采用第二个Law进行模型拟合,以此将上游损失与实际任务的表现相联系。然而,这一初步阶段遇到了不少难题。首先,数据量不足,此时选择拟合函数主要依赖个人直觉。此外,将两者关联起来的过程相当复杂,需要考虑众多因素。

研究进展较为迟缓。因为这些问题尚未解决,我们想要精确评估模型性能,尤其是通过Law等方法,还有很长的路要走。创新的技术和充足的数据支持是不可或缺的。

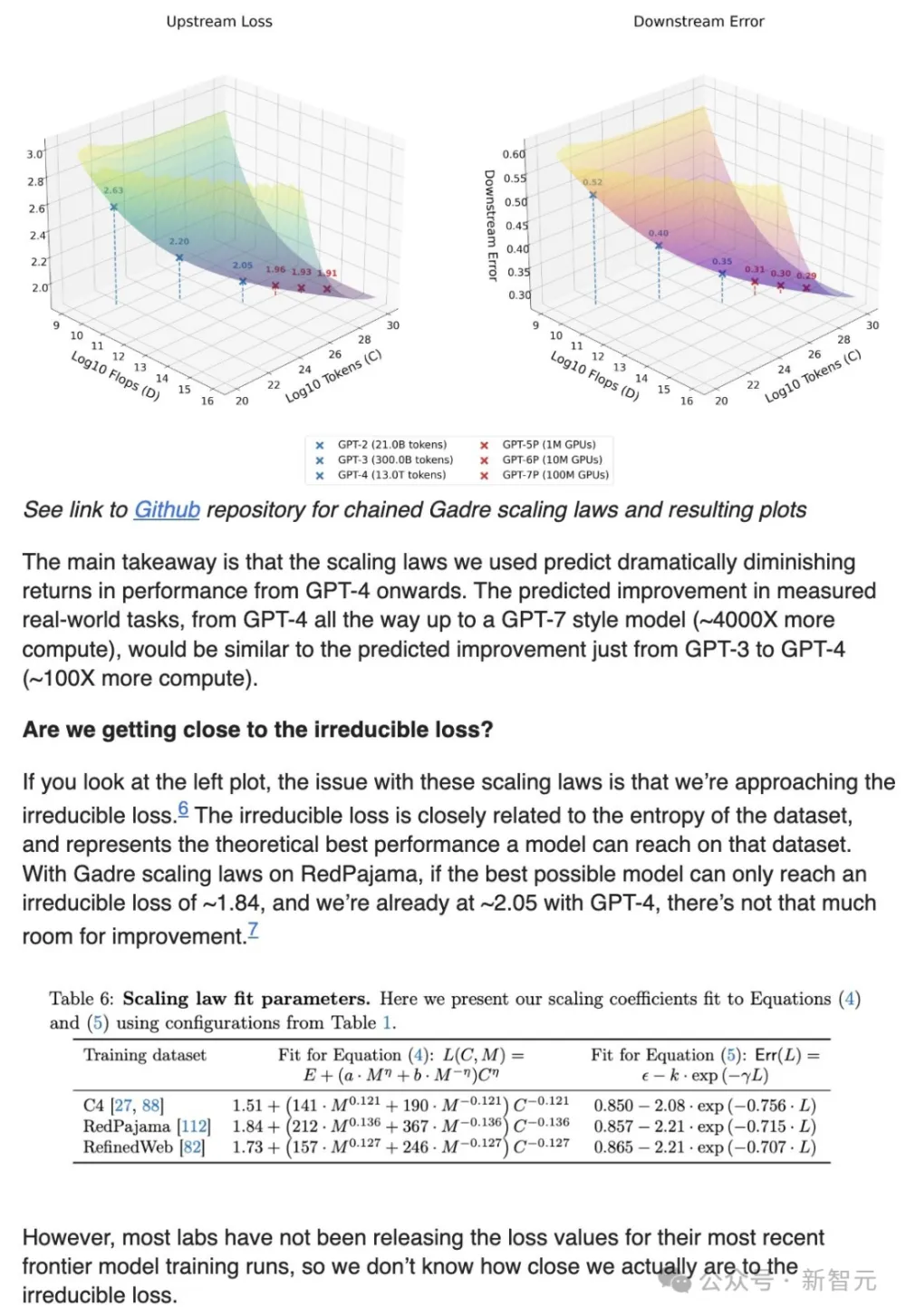

模型规模扩展的预测

借助现有研究,如用蓝色标记当前模型表现、红色点展示模型规模扩展等可视化手段,我们试图对模型未来性能作出推测。存在多方面改进空间,比如采用更优的算法、更精准的数据预测和计算。然而,由于下一代模型可能在结构或数据组合上有所创新,目前尚无法确切预知其扩展后的具体能力。

这情形就如同试探着过河,无论是谷歌的CEO在考虑对基础设施的投入,亦或是整个科技行业对于未来技术发展的预测,都面临着很高的不确定性。

正确看待AI发展

现在得认真思考AI的成长路径。不能盲目崇拜那些光鲜亮丽的概念。得从我们向AI提问的过程,到背后的人力支持,再到强化学习和人类反馈,以及模型预测的准确性,都要客观分析。别过分夸大AI的能力,得认识到它还有很多不足。大家觉得我们是不是对AI太过热情了?希望各位点赞转发,并在评论区分享你们的看法。